聊天機(jī)器人語(yǔ)言理解模塊開(kāi)發(fā)實(shí)踐

來(lái)源:原創(chuàng) 時(shí)間:2017-11-29 瀏覽:0 次

之前同享過(guò)一場(chǎng)Chat:“從零開(kāi)端,開(kāi)發(fā)一款談天機(jī)器人”�,其方針是為零根底開(kāi)發(fā)者供給一個(gè)最簡(jiǎn)版的chat bot開(kāi)發(fā)流程�。依照這個(gè)流程�,一個(gè)有根本編程閱歷,但沒(méi)有AI常識(shí)的人��,也能夠在短時(shí)刻里開(kāi)宣布一款自己的bot���。

本著這樣的目的,前次同享的要點(diǎn)�,不在某個(gè)詳細(xì)的技能點(diǎn),而是講怎樣運(yùn)用已有的AI技能�、結(jié)構(gòu)�、東西,來(lái)處理實(shí)踐問(wèn)題���。AI關(guān)于社會(huì)實(shí)在的奉獻(xiàn)并不是某一個(gè)模型算法多么炫酷深邃���,而是它能夠?yàn)楸M量多的人所運(yùn)用,來(lái)做實(shí)事�����。

因而��,在前次Chat在介紹Bot的言語(yǔ)了解(Language Understanding/LU)模塊時(shí)�,就選用了一款現(xiàn)成的在線LU東西:LUIS,而不是通知我們?cè)鯓幼约簩慙U模型����。

沒(méi)想到許多參加談?wù)摰耐瑢W(xué)對(duì)LU特別感愛(ài)好�����,想要知道目的辨認(rèn)和實(shí)體抽取終究是怎樣完成的�����。已然我們這樣感愛(ài)好����,并且在線LU東西又存在無(wú)法本地布置����,有concurrency約束等問(wèn)題,可能導(dǎo)致在某些場(chǎng)景(例如無(wú)法訪問(wèn)外網(wǎng)��,需求高concurrency或極低latency)下無(wú)法滿意需求����。因而,新開(kāi)本次的Chat���,從原理開(kāi)端�����,解說(shuō)言語(yǔ)了解模塊的工程完成��。

一���、談天機(jī)器人的言語(yǔ)了解模塊

談天機(jī)器人的言語(yǔ)了解有許多種完成技能��。在此��,我們持續(xù)上場(chǎng)chat里首要介紹的solution:關(guān)于用戶輸入問(wèn)題進(jìn)行目的辨認(rèn)和實(shí)體提取�。

前次講過(guò)�����,目的辨認(rèn)和言語(yǔ)提取能夠經(jīng)過(guò)依據(jù)規(guī)矩(rule-based))和依據(jù)模型(model-based)兩種辦法來(lái)完成�。

最簡(jiǎn)略直接的是依據(jù)規(guī)矩的辦法:用要害字/正則表達(dá)式匹配的辦法�,來(lái)發(fā)現(xiàn)自然言語(yǔ)中的目的和實(shí)體。

其實(shí)�����,如果我們真的去開(kāi)發(fā)一個(gè)以運(yùn)用為目的�����,筆直范疇內(nèi)答復(fù)有限問(wèn)題的Bot。就會(huì)發(fā)現(xiàn)�,最straight forward的辦法,就是去設(shè)置許多規(guī)矩���,進(jìn)行rule-based了解����。不只準(zhǔn)確率高���,并且特別好修正��,哪里有錯(cuò)����,直接改rule就好了����。還不需求預(yù)備操練語(yǔ)料,和model-based比起來(lái)�����,真是不知道好用到哪里去了。

可是��,終究依據(jù)規(guī)矩的辦法缺陷也很顯著:缺少泛化才能�。并且,從前次chat聽(tīng)眾發(fā)問(wèn)和談?wù)搧?lái)看���,我們最感愛(ài)好的���,偏偏是model-based LU。

的確��,model-based LU運(yùn)用到了Machine Learning的技能�����,離炫酷的AI最近�����。盡管在實(shí)踐傍邊�,用最小價(jià)值處理必要問(wèn)題的辦法就是最好的辦法��,選技能應(yīng)該選對(duì)的�,而不是“貴”的�����?���?墒?�,已然我們就喜愛(ài)“貴“的����,那我們就專門來(lái)講講它。

在講詳細(xì)算法模型之前��,我們先來(lái)看看NLP����。

二、NLP是怎樣回事

我們今日要講的言語(yǔ)了解�,是了解人類的自然言語(yǔ)(Natural Language)。這部分作業(yè)能夠算作自然言語(yǔ)處理(Natural Language Process/NLP)的一部分���。

當(dāng)然���,現(xiàn)在也有人把自然言語(yǔ)了解(NLU)獨(dú)自提出來(lái)���,當(dāng)作和NLP并排的另一個(gè)范疇。不過(guò)我們沒(méi)必要玩這種文字游戲�����。NLU也罷����,NLP也好,都要讓核算機(jī)“聽(tīng)懂”人類正常說(shuō)話時(shí)運(yùn)用的言語(yǔ)���,而不是幾個(gè)英文要害字加一堆參數(shù)的格式化的指令����。

我們?nèi)祟愂窃鯓恿私庋哉Z(yǔ)呢�?

舉個(gè)比方,我說(shuō)“蘋果”這個(gè)詞�,你會(huì)想到什么?一種酸酸甜甜紅紅綠綠的球狀生果�����,對(duì)吧���。想起來(lái)的時(shí)分����,或許腦子里會(huì)呈現(xiàn)蘋果的圖畫�����,或許會(huì)回味起它甜美的滋味����,或許想起和這種生果有關(guān)的什么作業(yè)。

我們?nèi)祟惲私庋哉Z(yǔ)的時(shí)分����,是把一個(gè)籠統(tǒng)的詞語(yǔ)和一個(gè)詳細(xì)的事物相關(guān)起來(lái),這個(gè)事物是我們腦筋中常識(shí)庫(kù)圖譜里的一個(gè)節(jié)點(diǎn)�,和周圍若干節(jié)點(diǎn)直接相連,和更多節(jié)點(diǎn)直接相連……

核算機(jī)又怎樣了解言語(yǔ)呢�����?

我們用鍵盤敲出“蘋果”兩個(gè)字的時(shí)分����,核算機(jī)并不會(huì)幻視出一個(gè)生果�,也不會(huì)像人那樣“意識(shí)到”這個(gè)單詞的含義���。

不管經(jīng)過(guò)輸出設(shè)備顯現(xiàn)成什么姿態(tài)�,核算機(jī)所實(shí)在能夠處理的�,是各式各樣的數(shù)值。要想讓核算機(jī)了解人類的言語(yǔ)�,就需求把人類的言語(yǔ)轉(zhuǎn)化成它能夠用來(lái)讀取、存儲(chǔ)���、核算的數(shù)值辦法�����。

當(dāng)若干自然言語(yǔ)被變換為數(shù)值之后�,核算機(jī)經(jīng)過(guò)在這些數(shù)值之上的一系列運(yùn)算來(lái)斷定它們之間的聯(lián)絡(luò)�����,再依據(jù)一個(gè)全集之中單個(gè)之間的彼此聯(lián)絡(luò)��,來(lái)斷定某個(gè)單個(gè)在全體(全集)中的方位�����。

這么說(shuō)有點(diǎn)繞����,仍是回到比方上。很可能��,我說(shuō)“蘋果”的時(shí)分�����,有些人首要想到的不是蘋果����,而是喬幫主創(chuàng)建的科技公司。

可是��,我持續(xù)說(shuō):“蘋果必定要生吃��,蒸熟了再吃就不脆了���。”——在這句話里�,“蘋果”一詞斷定無(wú)疑指的是生果����,而不是公司���。由于在我們的常識(shí)庫(kù)里,都知道生果能夠吃�,可是公司不能吃。呈現(xiàn)在同一句話中的 “吃”對(duì)“蘋果”起到了限制作用——這是人類的了解����。

關(guān)于核算機(jī),當(dāng)若干包括“蘋果”一詞的文檔被輸入進(jìn)去的時(shí)分���,“蘋果”被轉(zhuǎn)化為一個(gè)數(shù)值Va�����。經(jīng)過(guò)核算��,這個(gè)數(shù)值和對(duì)應(yīng)“吃”的數(shù)值Ve發(fā)生了某種直接的相關(guān)�����,而一起和Ve發(fā)生相關(guān)的還有若干數(shù)值���,它們對(duì)應(yīng)的概念可能是“香蕉”(Vb)��、“菠蘿”(Vp)��、“獼猴桃”(Vc)……那么據(jù)此�����,核算機(jī)就會(huì)發(fā)現(xiàn)Va,Vb�����,Vp�,Vc之間的某些相關(guān)(怎樣運(yùn)用這些相關(guān),就要看詳細(xì)的處理需求了)��。

總結(jié)一下��,核算機(jī)處理自然言語(yǔ)必經(jīng)由兩個(gè)進(jìn)程:i)數(shù)值化和ii)核算�。

NOTE 1: 提到數(shù)值,我們可能天性的想到int, double, float……但實(shí)踐上���,如果將一個(gè)言語(yǔ)要素對(duì)應(yīng)成一個(gè)標(biāo)量的話�����,太簡(jiǎn)略呈現(xiàn)兩個(gè)正本相差甚遠(yuǎn)的概念經(jīng)過(guò)簡(jiǎn)略運(yùn)算持平的狀況�����。假定“蘋果“被轉(zhuǎn)化為2���,而”香蕉“被轉(zhuǎn)化為4�����,難道說(shuō)兩個(gè)蘋果等于一個(gè)香蕉嗎�?

因而����,一般在處理時(shí)會(huì)將自然言語(yǔ)轉(zhuǎn)化成n維向量。只需轉(zhuǎn)化辦法合理��,躲避向量之間由于簡(jiǎn)略運(yùn)算而引起歧義的狀況仍是比較簡(jiǎn)略的���。

NOTE2:詳細(xì)的轉(zhuǎn)化辦法有許多種(后邊章節(jié)會(huì)詳細(xì)介紹詳細(xì)辦法)�。不過(guò)��,已然要把“字”轉(zhuǎn)化為“數(shù)”,有一個(gè)天然的數(shù)值就很簡(jiǎn)略被選中����,這個(gè)數(shù)值就是:這個(gè)字的概率(在當(dāng)時(shí)文檔中,或許在一切文檔中)����。

由概率,我們又能夠引出一個(gè)概念:信息熵�。這個(gè)概念我們能夠自行百度,先看一下它的核算公式:

其間P(xi)就是xi的概率��??梢?jiàn)����,只需已知調(diào)會(huì)集每個(gè)元素的概率,就能夠求取調(diào)集的信息熵�����。

三�、言語(yǔ)了解模型

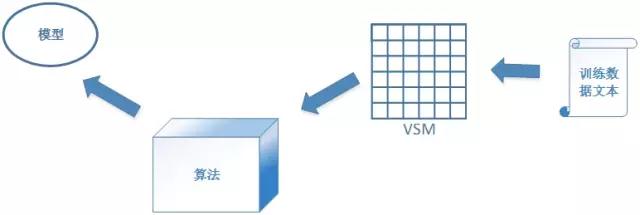

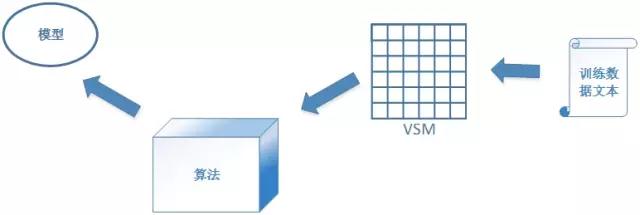

模型、算法���、VSM

本文所說(shuō)的LU 包括兩大功用:目的辨認(rèn)和實(shí)體提取��。

目的辨認(rèn)是一個(gè)典型的分類問(wèn)題�����,而實(shí)體抽取則是一個(gè)Sequence-to-Sequence判別問(wèn)題��。因而我們需求構(gòu)建一個(gè)分類模型和一個(gè)seq2seq判別模型�。

我們先來(lái)說(shuō)說(shuō)模型是什么。

一個(gè)現(xiàn)已操練好的模型能夠被了解成一個(gè)公式 y=f(x)��,我們把數(shù)據(jù)(對(duì)應(yīng)其間的x)輸入進(jìn)去����,得到輸出成果(對(duì)應(yīng)其間的y)。這個(gè)輸出成果可能是一個(gè)數(shù)值�,也可能是一個(gè)標(biāo)簽,它會(huì)通知我們一些作業(yè)����。

比方,我們把用戶說(shuō)的一句話輸入辨認(rèn)用戶目的的分類模型��。模型經(jīng)過(guò) 一番運(yùn)算�����,吐出一個(gè)標(biāo)簽,這個(gè)標(biāo)簽���,就是這句話的目的(intent)�����。

把這句話再輸入到實(shí)體提取模型里邊�����,模型會(huì)吐出一個(gè)List���,其間每一個(gè)element都是一個(gè)實(shí)體��,這個(gè)實(shí)體的信息包括:i)實(shí)體名:輸入句子中一個(gè)的片段�����;ii)實(shí)體方位:該片段在輸入句子中的方位和長(zhǎng)度��;iii)實(shí)體類型:該片段所對(duì)應(yīng)的實(shí)體歸于什么類型���。

模型是怎樣得到的�����?

模型是依據(jù)數(shù)據(jù)���,經(jīng)由操練得到的���。操練又是怎樣回事?

當(dāng)我們把模型作為y=f(x)時(shí)���,x就是其間的自變量�����,y是因變量��。從x核算出y要看f(x)是一個(gè)詳細(xì)什么樣的公式�,這個(gè)公式中還有哪些參數(shù)�,這些參數(shù)的值都是什么。操練的進(jìn)程就是得到詳細(xì)的某個(gè)f(x)��,和其間各個(gè)參數(shù)的詳細(xì)取值的進(jìn)程�����。

在開(kāi)端操練的時(shí)分,我們一切的是x的一些樣本數(shù)據(jù)���,這些樣本自身即有自變量(特征)也有因變量(預(yù)期成果)���。對(duì)應(yīng)于y=f(x)中的x和y取值實(shí)例。這個(gè)時(shí)分�����,由于現(xiàn)已選定了模型類型����,我們現(xiàn)已知道了f(x)的形制,比方是一個(gè)線性模型y=f(x)=ax^2+bx+c����,但卻不知道里邊的參數(shù)a, b, c的值�。

操練,就是要將已有樣本經(jīng)過(guò)依據(jù)某種規(guī)矩的運(yùn)算�����,得到那些參數(shù)的值,由此得到一個(gè)通用的f(x)��。這些運(yùn)算的規(guī)矩�����,就叫做:算法�。

提到算法,就觸及到了機(jī)器學(xué)習(xí)的內(nèi)容�,經(jīng)過(guò)幾十年的研討,現(xiàn)已有許多現(xiàn)成的算法能夠用于取得不同類型的模型����。關(guān)于生成分類模型和seq2seq判別模型的算法,我們下面有專門章節(jié)談?wù)摗?/span>

要得到模型��,算法當(dāng)然重要���,但往往更重要的是數(shù)據(jù)�����。

用于操練模型的數(shù)據(jù)有個(gè)專名的稱號(hào)稱號(hào)它們:操練數(shù)據(jù)�����。操練數(shù)據(jù)的調(diào)集叫做操練集�。

分類模型和seq2seq判別模型的操練都?xì)w于有監(jiān)督學(xué)習(xí),因而�����,一切的操練數(shù)據(jù)都是標(biāo)示數(shù)據(jù)��。

因而�����,在進(jìn)入操練階段前必需求經(jīng)過(guò)一個(gè)進(jìn)程:人工標(biāo)示�。這部分現(xiàn)已在之前chat中講過(guò),不贅述���。

標(biāo)示的進(jìn)程繁瑣且作業(yè)量頗大����?����?墒侵恍柽M(jìn)行有監(jiān)督學(xué)習(xí)��,就無(wú)法越過(guò)這一步����。偏偏許多在實(shí)踐中證明的確有用的模型都是有監(jiān)督學(xué)習(xí)模型。因而�����,如果我們真的在作業(yè)中運(yùn)用機(jī)器學(xué)習(xí)���,標(biāo)示就是無(wú)法跨越的臟活累活��,是必經(jīng)的pain���。

這兒需求提示我們的是:人工標(biāo)示的進(jìn)程看似簡(jiǎn)略,但實(shí)踐上���,標(biāo)示戰(zhàn)略和質(zhì)量對(duì)終究生成模型的質(zhì)量有直接影響���。而往往能夠決議模型質(zhì)量的不是深邃的算法和精細(xì)的模型,而是高質(zhì)量的標(biāo)示數(shù)據(jù)����。因而�����,對(duì)標(biāo)示���,切莫小歔。

此處有一點(diǎn)和之前NLP一節(jié)照應(yīng)����,就是:任何算法的處理方針都是數(shù)值。

而我們要對(duì)其進(jìn)行分類和辨認(rèn)的方針卻是自然言語(yǔ)文本����。因而需求一個(gè)進(jìn)程,把原始文字辦法的操練數(shù)據(jù)轉(zhuǎn)化為數(shù)值辦法�。

為了做到這一點(diǎn),我們需求構(gòu)建一個(gè)向量空間模型(Vector Space Model/VSM)���。VSM擔(dān)任將一個(gè)個(gè)自然言語(yǔ)文檔轉(zhuǎn)化為一個(gè)個(gè)向量�����。下面也會(huì)專門章節(jié)講VSM的構(gòu)建���。

操練數(shù)據(jù)經(jīng)過(guò)VSM變換之后��,我們把這些變換成的向量輸入給分類或辨認(rèn)算法,進(jìn)入正式的操練進(jìn)程��。操練的輸出成果��,就是模型��。

怎樣判別模型的好壞

經(jīng)過(guò)操練得到模型后�,我們需求用模型來(lái)對(duì)用戶不斷輸入的句子進(jìn)行猜測(cè)(也就是把用戶句子輸入到模型中讓模型吐出一個(gè)成果)。

猜測(cè)必定能出成果��,至于這個(gè)猜測(cè)成果是否是你想要的����,就不必定了。一般來(lái)說(shuō)�����,沒(méi)有任何模型能百分百確保盡善盡美����,但我們總是尋求盡量好。

什么樣的模型算好呢?當(dāng)然需求測(cè)驗(yàn)�。當(dāng)我們操練出了一個(gè)模型今后,為了斷定它的質(zhì)量��,需求用一些知道預(yù)期猜測(cè)成果的數(shù)據(jù)來(lái)對(duì)其進(jìn)行測(cè)驗(yàn)���。這些用于測(cè)驗(yàn)的數(shù)據(jù)的調(diào)集�,叫做測(cè)驗(yàn)集��。

一般來(lái)說(shuō)�,除了操練集和測(cè)驗(yàn)集,還會(huì)需求驗(yàn)證集:

操練集(Train Set)用來(lái)操練數(shù)據(jù)����。

驗(yàn)證集(Validation Set)用來(lái)在操練的進(jìn)程中優(yōu)化模型(模型優(yōu)化在下面也會(huì)獨(dú)自講)。

測(cè)驗(yàn)集(Test Set)用來(lái)查驗(yàn)終究得出的模型的功用�����。

操練集有必要是獨(dú)立的����,和驗(yàn)證集、測(cè)驗(yàn)集都無(wú)關(guān)�。驗(yàn)證集和測(cè)驗(yàn)集在單個(gè)狀況下只需一份�����,不過(guò)當(dāng)然最好仍是分隔���。這三個(gè)調(diào)集能夠從同一份標(biāo)示數(shù)據(jù)中隨機(jī)選取。三者的份額能夠是操練集:驗(yàn)證集:測(cè)驗(yàn)集=2:1:1�����,也能夠是7:1:2��?���?倸w�,測(cè)驗(yàn)集占大頭。

在用測(cè)驗(yàn)集做測(cè)驗(yàn)時(shí)��,我們需求一些詳細(xì)的評(píng)估方針來(lái)評(píng)判成果的好壞�。關(guān)于分類和seq2seq辨認(rèn)模型而言,評(píng)估規(guī)范能夠通用����。最簡(jiǎn)略也是最常見(jiàn)的驗(yàn)證方針:精準(zhǔn)率(Precision)和召回率(Recall)�,為了歸納這兩個(gè)方針并得出量化成果��,又發(fā)明晰F1Score�����。

對(duì)一個(gè)分類模型而言���,給它一個(gè)輸入��,它就會(huì)輸出一個(gè)標(biāo)簽���,這個(gè)標(biāo)簽就是它猜測(cè)的當(dāng)時(shí)輸入的類別。假定數(shù)據(jù)data1被模型猜測(cè)的類別是Class_A����。那么,關(guān)于data1就有兩種可能性:data1正本就是Class_A(猜測(cè)正確)��,data1正本不是Class_A(猜測(cè)過(guò)錯(cuò))�。

當(dāng)一個(gè)測(cè)驗(yàn)集悉數(shù)被猜測(cè)完之后,相關(guān)于Class_A����,會(huì)有一些實(shí)踐是Class_A的數(shù)據(jù)被猜測(cè)為其他類�,也會(huì)有一些其實(shí)不是Class_A的����,被猜測(cè)成Class_A,這樣的話就導(dǎo)致了下面這個(gè)成果

實(shí)踐/猜測(cè) 猜測(cè)類為Class_A 猜測(cè)類為其他類

實(shí)踐類為Class_A TP:實(shí)踐為Class_A���,也被正確猜測(cè)的測(cè)驗(yàn)數(shù)據(jù)條數(shù) FN:實(shí)踐為Class_A����,但被猜測(cè)為其他類的測(cè)驗(yàn)數(shù)據(jù)條數(shù)

實(shí)踐類為其他類 FP:實(shí)踐不是Class_A�,但被猜測(cè)為Class_A的數(shù)據(jù)條數(shù) TN:實(shí)踐不是Class_A�,也沒(méi)有被測(cè)驗(yàn)為Class_A的數(shù)據(jù)條數(shù)

精準(zhǔn)率:Precision=TP/(TP+FP),即在一切被猜測(cè)為Class_A的測(cè)驗(yàn)數(shù)據(jù)中���,猜測(cè)正確的比率����。

召回率:Recall=TP/(TP+FN)���,即在一切實(shí)踐為Class_A的測(cè)驗(yàn)數(shù)據(jù)中���,猜測(cè)正確的比率�。

F1Score = 2*(Precision * Recall)/(Precision + Recall)�����。

顯著上面三個(gè)值都是越大越好�����,但往往在實(shí)踐傍邊P和R是對(duì)立的��,很難確保雙高��。

此處需求留意����,P,R���,F(xiàn)1Score在分類問(wèn)題中都是對(duì)某一個(gè)類而言的�。也就是說(shuō)假定這個(gè)模型總共能夠分10個(gè)類�,那么關(guān)于每一個(gè)類都有一套獨(dú)立的P,R��,F(xiàn)1Score的值�����。衡量模型全體質(zhì)量,要?dú)w納看一切10套方針���,而不是只看一套�����。

一起���,這套方針還和測(cè)驗(yàn)數(shù)據(jù)有關(guān)。相同的模型���,換一套測(cè)驗(yàn)數(shù)據(jù)后��,很可能P,R�,F(xiàn)1Score會(huì)有改變,如果這種改變超過(guò)了必定起伏���,就要考慮是否存在bias或許overfitting的狀況����。

seq2seq辨認(rèn)實(shí)踐上能夠看作是一種方位相關(guān)的分類。每一種實(shí)體類型都能夠被看作一個(gè)類別�,因而也就相同適用P,R����,F(xiàn)1Score方針。

此外還有ROC曲線�,PR曲線,AUC等評(píng)估方針���,我們能夠自行查詢參閱��。

構(gòu)建模型的進(jìn)程

籠統(tǒng)而言�����,為了構(gòu)建一個(gè)模型����,我們需求閱歷以下進(jìn)程:

搜集語(yǔ)料(搜集被標(biāo)示的數(shù)據(jù))

標(biāo)示數(shù)據(jù)

將標(biāo)示數(shù)據(jù)切分為操練集���、驗(yàn)證集和測(cè)驗(yàn)集

構(gòu)建VSM

選取算法

操練(期間要閱歷屢次迭代優(yōu)化�����,在驗(yàn)證集上抵達(dá)最優(yōu))

測(cè)驗(yàn)

談天機(jī)器人的言語(yǔ)了解需求兩個(gè)模型���,那么上面這套進(jìn)程就需求做兩遍����。

其間僅有有可能同享的��,是第一步:搜集語(yǔ)料����。但并不是說(shuō)兩個(gè)模型只能用同一套語(yǔ)料。實(shí)踐中���,兩份語(yǔ)料往往是有一部分overlap��,但并不全相同��。

語(yǔ)料來(lái)歷何處�?

有一些bot的開(kāi)發(fā)目的是為了輔佐或許部分代替已有的人工客服�����。這種狀況下����,往往之前人工客服和用戶對(duì)話的log現(xiàn)已積累了許多。從中挑選出比較典型的用戶發(fā)問(wèn)句子�,就能夠用來(lái)做模型需求的語(yǔ)料。

如果是冷啟動(dòng)的bot���,相對(duì)困難一點(diǎn)���。可能需求在最開(kāi)端的時(shí)分自動(dòng)造一些語(yǔ)料����。開(kāi)發(fā)者幻想自己是用戶,把有可能發(fā)問(wèn)的句子直接記錄下來(lái)作為下面要用的語(yǔ)料����。

如果是這樣做的話,最好由多個(gè)人來(lái)一起結(jié)構(gòu)語(yǔ)料��。根本上結(jié)構(gòu)語(yǔ)料的人越多�����,語(yǔ)料與實(shí)在環(huán)境的搜集成果也就越挨近。

這以后的每一步����,兩個(gè)模型就都是自顧自了。標(biāo)示部分����,請(qǐng)拜見(jiàn)上場(chǎng)chat。

四���、構(gòu)建VSM

之前提到了VSM����,我們來(lái)看看詳細(xì)怎樣結(jié)構(gòu)���。

假定操練會(huì)集包括N個(gè)用戶問(wèn)題�����,我們把每個(gè)問(wèn)題稱為一個(gè)文檔(document)��,你要把這N個(gè)文檔變換成N個(gè)與之一一對(duì)應(yīng)的向量���。

再假定每個(gè)向量包括M維。那么終究�����,當(dāng)悉數(shù)變換完之后��,整個(gè)操練集就構(gòu)成了一個(gè)NxM的矩陣(Matrix)�����,這就是向量空間模型(Vector Space Model��,VSM)���。

其間�����,M是你的悉數(shù)操練集文本(一切N個(gè)文檔)中包括的Term數(shù)��。這個(gè)Term詳細(xì)是一個(gè)字�、一個(gè)詞仍是其他什么����,實(shí)踐是由VSM的構(gòu)建者自己來(lái)斷定����。

關(guān)于中文而言�,這個(gè)Term比較常見(jiàn)的有兩種挑選,一個(gè)是分詞后的單個(gè)詞語(yǔ)�����,另一個(gè)是n-gram辦法提取的Term��。

n-gram中的n和文檔個(gè)數(shù)的N無(wú)關(guān)(此處特別用巨細(xì)寫來(lái)差異他們)��,這個(gè)n是一個(gè)由你斷定的值��,它指的是最長(zhǎng)Term中包括的漢字的個(gè)數(shù)��。一般狀況下��,我們選n=2就好了���。當(dāng)n==2時(shí)的n-gram又叫做bigram����。n==1時(shí)叫unigram��,n==3時(shí)叫trigram。

N個(gè)文檔���,設(shè)其間第i個(gè)文檔的Term數(shù)為ci個(gè)(i 取值區(qū)間為[1, N])���。那么這N個(gè)文檔別離有:c1,c2...cn個(gè)Term����。這些Term中必定有些是重復(fù)的。我們對(duì)一切這些Term做一個(gè)去重操作���,終究得出的無(wú)重復(fù)Term的個(gè)數(shù)就是M���。

針對(duì)詳細(xì)的一個(gè)文檔,我們就能夠構(gòu)建一個(gè)M維的向量�����,其間每一維對(duì)應(yīng)這M個(gè)Term中的一個(gè)��。

每一個(gè)維度的值��,都是一個(gè)實(shí)數(shù)(一般在核算機(jī)處理中是float或許double類型)�����。這個(gè)實(shí)數(shù)值,一般的狀況下���,取這一維度所對(duì)應(yīng)Term在悉數(shù)操練文檔中的TF-IDF(請(qǐng)自行百度TF-IDF)����。

假定我們一同處理了1萬(wàn)個(gè)文檔(N == 10000)��,總共得出了2萬(wàn)個(gè)Term (M == 20000)���。這樣就得到了一個(gè)10000 x 20000的矩陣����。其間���,每個(gè)Vector都只需20多個(gè)維度有非零值�,實(shí)在是太稀少了����。

這樣稀少的矩陣恐怕也不會(huì)有太好的運(yùn)算作用。并且�����,一些差異度過(guò)大的Term(例如某一個(gè)Term僅僅只在一個(gè)或許很少的文檔中呈現(xiàn)),在經(jīng)過(guò)運(yùn)算之后往往會(huì)具有過(guò)大的權(quán)重��,導(dǎo)致之后只需一個(gè)文檔包括這個(gè)Term就會(huì)被歸到某一個(gè)類����。這種狀況顯著是我們要防止的�����。

因而���,我們最好先對(duì)一切的Term做一個(gè)挑選�����。此處講兩個(gè)特別簡(jiǎn)略和常見(jiàn)的Term挑選辦法:

設(shè)定DF(DocumentFrequency)的下限�。設(shè)定一個(gè)Threshold (e.g. DF_Threshold = 2)����,若一個(gè)Term的DF小于該Threshold,則將該Term棄之不必����。

依據(jù)每個(gè)Term的信息熵對(duì)其進(jìn)行挑選���。

一個(gè)Term的信息熵(Entroy)體現(xiàn)了該Term在不同類別中的散布狀況。一般來(lái)說(shuō)����,一個(gè)Term的Entropy越大,則闡明它在各個(gè)類中均勻呈現(xiàn)的概率越大����,因而差異度就越小���;反之���,Entroy越小也就闡明該Term的類別差異度越大。我們當(dāng)然要選用Entroy盡量小的Term�。詳細(xì)選用多少,能夠自己界說(shuō)一個(gè)Threshold�����。

Entropy_Threshold能夠是一個(gè)數(shù)字(例如8000),也能夠是一個(gè)百分比(例如40%)��。核算了一切Term的Entropy之后����,按Entropy從小到大排序,選取不大于Entropy_Threshold的前若干個(gè)����,作為終究構(gòu)建VSM的Term。

假定一切的操練樣本總共被分為K類�,則Entropy的核算辦法如下(設(shè)tx表明某個(gè)詳細(xì)的Term):Entropy(tx) = Sigmai -- i取值規(guī)模為[1,K]

其間,P(ci) 表明tx在第i個(gè)列別中的呈現(xiàn)概率����,詳細(xì)核算辦法選用softmax算法:

P(ci)= exp(y(ci)) /Sigmaj -- j取值規(guī)模為[1,K]

其間y(ci) 為tx在類別j中呈現(xiàn)的次數(shù)����。

經(jīng)過(guò)挑選,M個(gè)Term縮減為M' 個(gè),我們NxM' 矩陣變得愈加精粹有用了�����。這也就是我們終究的VSM�����。

五、分類模型

分類模型是機(jī)器學(xué)習(xí)中最常用的一類模型�,常用的分類模型就有:Naïve Bayes,Logistic Regression����,Decision Tree,SVM等����。今日我們?cè)谶@兒介紹其間的Logistic Regression。它也是之前我們介紹的LUIS(https://luis.ai)做目的辨認(rèn)時(shí)用到的模型�����。

LR模型的原理及方針函數(shù)

Logistic regression (LR���,一般翻譯為邏輯回歸)是一種簡(jiǎn)略��、高效的常用分類模型�。它典型的運(yùn)用是二分類問(wèn)題上��,也就是說(shuō)�����,把一切的數(shù)據(jù)只分為兩個(gè)類。當(dāng)然�,這并不是說(shuō)LR不能處理多分類問(wèn)題,它當(dāng)然能夠處理��,詳細(xì)辦法稍后講����。我們先來(lái)看LR自身。

如前所述����,模型能夠被看做一個(gè)辦法斷定、參數(shù)值待定的函數(shù)��。LR對(duì)應(yīng)的這個(gè)函數(shù)����,我們記作:y=h(x)��。

其間自變量x是向量��,物理含義是一系列特征��,在bot LU的scenario之下,這些特征值就是用戶問(wèn)題經(jīng)過(guò)VSM變換后得出的向量����。

而終究核算出的因變量y,則是一個(gè)[0,1]區(qū)間之內(nèi)的實(shí)數(shù)值��。當(dāng)y>0.5 時(shí)����,x 被歸類為陽(yáng)性(Positive),不然當(dāng)y <=0.5時(shí)��,被歸類為陰性(Negative)�����。

如果單純看這個(gè)取值�����,是不是會(huì)有點(diǎn)憂慮�����,如果許多的輸入得到的成果都在y=0.5鄰近��,那豈不是很簡(jiǎn)略分錯(cuò)?說(shuō)得極點(diǎn)一點(diǎn)���,如果一切的輸入數(shù)據(jù)得出的成果都在y=0.5鄰近�,那豈不是沒(méi)有什么分類含義了����,和隨機(jī)亂歸類成果差不多?

這樣的憂慮其實(shí)是不必要的���,由于LR的模型對(duì)應(yīng)公式是:

這個(gè)公式對(duì)應(yīng)的散布是這樣的:

發(fā)現(xiàn)沒(méi)有����,此函數(shù)在y=0.5鄰近十分靈敏�,自變量取值稍有不同,因變量取值就會(huì)有很大差異����,所以不必憂慮呈現(xiàn)許多因纖細(xì)特征差異而被歸錯(cuò)類的狀況。

上述的h(x) 是我們要經(jīng)過(guò)操練得出來(lái)的終究成果�����,可是在最開(kāi)端的時(shí)分��,我們是不知道其間的參數(shù)theta的�����,我們一切的僅僅若干的x和與其對(duì)應(yīng)的y(操練調(diào)集)�����。

怎樣經(jīng)過(guò)操練數(shù)據(jù)中已知的x和y來(lái)求不知道的theta呢���?

首要要么要設(shè)定一個(gè)方針:我們期望這個(gè)終究得出的theta抵達(dá)一個(gè)什么樣的作用——我們當(dāng)然是期望得出來(lái)的這個(gè)theta��,能夠讓操練數(shù)據(jù)中被歸為陽(yáng)性的數(shù)據(jù)猜測(cè)成果為陽(yáng)�����,正本被分為陰性的猜測(cè)成果為陰�。

而從公式自身的視點(diǎn)來(lái)看���,h(x)實(shí)踐上是x為陽(yáng)性的散布概率��,所以�,才會(huì)在h(x) > 0.5時(shí)將x歸于陽(yáng)性��。也就是說(shuō)h(x) = P(y=1)。反之���,樣例是陰性的概率P(y=0) = 1 - h(x)���。

當(dāng)我們把測(cè)驗(yàn)數(shù)據(jù)帶入其間的時(shí)分,P(y=1)和P(y=0)就都有了先決條件���,它們?yōu)椴倬殧?shù)據(jù)的x所限制���。因而P(y=1|x) = h(x); P(y=0|x) = 1- h(x)。

依據(jù)二項(xiàng)散布公式�,可得出P(y|x) = h(x) ^y*(1- h(x))^(1-y)。

假定我們的操練集總共有m個(gè)數(shù)據(jù)�,那么這m個(gè)數(shù)據(jù)的聯(lián)合概率就是:

我們求取theta的成果,就是讓這個(gè)L(theta)抵達(dá)最大����。上面這個(gè)函數(shù)就叫做LR的似然函數(shù)。為了好核算�����,我們對(duì)它求對(duì)數(shù)�。得到對(duì)數(shù)似然函數(shù):

我們要做的就是求出讓l(theta) 能夠得到最大值的theta����。l(theta) 就是LR的方針函數(shù)�。

NOTE:方針函數(shù)是機(jī)器學(xué)習(xí)的中心��。機(jī)器學(xué)習(xí)要做的最要害的作業(yè)就是將一個(gè)實(shí)踐問(wèn)題籠統(tǒng)為數(shù)學(xué)模型�,將處理這個(gè)問(wèn)題的辦法籠統(tǒng)問(wèn)一個(gè)能夠以某種斷定性手法(最大化、最小化)使其抵達(dá)最優(yōu)的方針函數(shù)����。

在此,我們現(xiàn)已得到了LR的方針函數(shù)l(theta)����,并且優(yōu)化方針是最大化它。為了取得l(theta)的最大值�,我們要對(duì)它求導(dǎo):

由于l(theta)為凸函數(shù),因而當(dāng)其導(dǎo)數(shù)函數(shù)為0時(shí)原函數(shù)抵達(dá)最大值�。所以,我們要求取的��,就是上述公式為0時(shí)的theta�����,其間的y(i)和x(i)都是已知的。

LR的算法

上面是LR的根本原理和公式����。在上述方針函數(shù)的導(dǎo)函數(shù)中,如果求解theta呢�����?詳細(xì)辦法有許多�,我們?cè)诖藘H介紹最常見(jiàn)最根底的梯度下降算法。

我們現(xiàn)已知道l(theta)函數(shù)是有極值的��,那么怎樣去找到這個(gè)極值呢����?

我們能夠試,即先找到這個(gè)函數(shù)上的一點(diǎn)p1�,算出它的函數(shù)值,然后沿著該點(diǎn)導(dǎo)數(shù)方向行進(jìn)一步����,跨到p2點(diǎn),再核算出p2點(diǎn)所對(duì)應(yīng)的函數(shù)值��,然后不斷迭代,直到找到函數(shù)值收斂的點(diǎn)中止:

Set initial value: theta(0), alpha

while (not convergence)

{

}

其間�����,參數(shù)α叫學(xué)習(xí)率�,就是每一步的步長(zhǎng)。步長(zhǎng)的巨細(xì)很要害��,如果步長(zhǎng)過(guò)大�����,很可能會(huì)跨過(guò)極值點(diǎn)�����,總也無(wú)法抵達(dá)收斂����。步長(zhǎng)太小����,則需求的迭代次數(shù)太多,操練速度過(guò)慢�。能夠測(cè)驗(yàn)在前期的若干輪迭代中設(shè)置一個(gè)較大的步長(zhǎng),之后再縮小步長(zhǎng)持續(xù)迭代。

詳細(xì)判別收斂的辦法能夠是判別兩次迭代之間的差值小于某個(gè)閾值?(即比閾值小就中止)����。有時(shí)分,在實(shí)踐運(yùn)用中會(huì)強(qiáng)行規(guī)則一個(gè)迭代次數(shù)�����,到了這個(gè)次數(shù)不管收斂與否都先中止�。詳細(xì)推出迭代條件要按實(shí)踐需求斷定。

LR處理多分類問(wèn)題

LR是用來(lái)做而分類的��,我們的目的辨認(rèn)必定不是只需兩個(gè)目的啊����,怎樣能用LR?��!

別急���,LR一樣能夠做多分類����,不過(guò)就是要做屢次���。

假定你總共有n個(gè)intent����,也就是說(shuō)可能的分類總共有n個(gè)。那么就結(jié)構(gòu)n個(gè)LR分類模型�����,第一個(gè)模型用來(lái)差異intent_1和non-intent_1(即一切不歸于intent_1的都?xì)w屬到一類)����,第二個(gè)模型用來(lái)差異intent_2和non-intent_2���,..., 第n個(gè)模型用來(lái)差異intent_n和non-intent_n�。

運(yùn)用的時(shí)分����,每一個(gè)輸入數(shù)據(jù)都被這n個(gè)模型一起猜測(cè)。終究哪個(gè)模型得出了positive成果�,就是該數(shù)據(jù)終究的成果。

如果有多個(gè)模型都得出了positive��,那也沒(méi)有聯(lián)絡(luò)���。由于LR是一個(gè)回歸模型���,它直接猜測(cè)的輸出不僅僅一個(gè)標(biāo)簽�����,還包括該標(biāo)簽正確的概率����。那么比照幾個(gè)positive成果的概率����,選最高的一個(gè)就是了。

例如:有一個(gè)數(shù)據(jù)��,第一和第二個(gè)模型都給出了positive成果�����,不過(guò)intent_1模型的猜測(cè)值是0.95�,而intent_2的成果是0.78,那么當(dāng)然是選高的�����,成果就是intent_1。

六�、seq2seq判別模型

seq2seq判別模型在必定程度上也有分類的意味。不同之處在于����,seq2seq傍邊每一個(gè)被分類的片段,終究終究被分為哪個(gè)類��,除了與其自身相關(guān)�����,還與其前后片段的彼此方位有關(guān)���。

在文本處理傍邊,linear-chain CRF(線性鏈CRF)是最常用的一種seq2seq判別模型����,也是LUIS在做實(shí)體提取時(shí)用到的模型。

上圖顯現(xiàn)了LR和線性鏈CRF的聯(lián)絡(luò)與差異���。上圖中的灰色節(jié)點(diǎn)為輸入給模型的自變量(x1,x2,x3)��,而白色節(jié)點(diǎn)則是模型輸出的成果�。

可見(jiàn),LR中���,多個(gè)特征輸入后得到了僅有的分類成果���。而線性鏈CRF中,決議一個(gè)輸出的除了和它對(duì)應(yīng)的輸入�,還有排在它之前的那個(gè)輸出。

舉個(gè)比方:對(duì)“我要一張從北京到上海的機(jī)票����。” 進(jìn)行LR分類(目的辨認(rèn))的時(shí)分,整句話都被分為”購(gòu)買機(jī)票”目的����。而當(dāng)對(duì)其進(jìn)行線性鏈CRF判別時(shí),則會(huì)將”北京”抽取為出發(fā)地��,”上海”抽取為抵達(dá)地���。

直觀的來(lái)看�,我們也不難發(fā)現(xiàn)��,當(dāng)運(yùn)轉(zhuǎn)線性鏈CRF時(shí)��,“從”字在“北京”之前,“到”在“上海” 之前���;并且���,在判別抵達(dá)地時(shí),前面現(xiàn)已抽取出了出發(fā)地����,這些都對(duì)當(dāng)時(shí)的判別有所奉獻(xiàn)。

線性鏈CRF模型的原理及方針函數(shù)

線性鏈條件隨機(jī)場(chǎng)的界說(shuō)是: 設(shè)X=(X1,X2,...,Xn), Y=(Y1,Y2,...,Yn)均為線性鏈表明的隨機(jī)變量序列���,若在給定隨機(jī)變量序列X的條件下���,隨機(jī)變量序列Y的條件概率散布P(Y|X)滿意馬爾可夫性(請(qǐng)自行查找馬爾科夫性界說(shuō)), 則稱P(Y|X)為線性鏈條件隨機(jī)場(chǎng)。

在實(shí)體提取問(wèn)題中��,X表明輸入觀測(cè)序列(用戶問(wèn)題)��,Y表明對(duì)應(yīng)的輸出符號(hào)序列(實(shí)體類型)�。

線性鏈條件隨機(jī)場(chǎng)的模型:

線性鏈CRF模型表明:給定輸入序列x���,對(duì)輸出序列y進(jìn)行猜測(cè)的條件概率����。

其間,上式右側(cè)分母部分是規(guī)范化因子��。

t(k) 是鏈狀圖中邊的特征函數(shù)�����,稱為搬運(yùn)特征(t for transition)����,依賴于當(dāng)時(shí)和前一個(gè)方位,s(l)是圖中節(jié)點(diǎn)的特征函數(shù)���,稱為狀況特征(s for status)��,依賴于當(dāng)時(shí)方位����。不管哪種特征函數(shù)��,都將當(dāng)時(shí)可能的y(i)作為參數(shù)���。它們都依賴于方位�����,是部分特征函數(shù)��。

一般��,特征函數(shù)t(k)和s(l)取值為1或0����;當(dāng)滿意特征條件時(shí)取值為1,不然為0���。lambda(k)和mu(l)是它們對(duì)應(yīng)的權(quán)值���。

為簡(jiǎn)潔起見(jiàn),將搬運(yùn)特征和狀況特征及其權(quán)值用一致的符號(hào)表明���。設(shè)有K1個(gè)搬運(yùn)特征��,K2個(gè)狀況特征����,K=K1+K2�,記作:

上式其實(shí)是對(duì)特征函數(shù)進(jìn)行編碼,編號(hào)的前K1個(gè)歸于搬運(yùn)特征����,后K2個(gè)歸于狀況特征。

然后����,對(duì)搬運(yùn)與狀況特征在各個(gè)方位i求和,記作:

其間盡管有4個(gè)參數(shù)的辦法��,但對(duì)狀況特征函數(shù)而言���,y(i-1)會(huì)被疏忽掉��。

用wk表明特征fk(y,x)的權(quán)值���,即:

所以,線性鏈條件隨機(jī)場(chǎng)模型可簡(jiǎn)化表明為:

其間���,右側(cè)分母為歸一化因子��, wk為模型的參數(shù)�����, fk(x,y)為特征函數(shù)(feature function)�。

線性鏈條件隨機(jī)場(chǎng)模型實(shí)踐上是界說(shuō)在時(shí)序數(shù)據(jù)上的對(duì)數(shù)線形模型,其學(xué)習(xí)辦法包括極大似然估量和正則化的極大似然估量��。它的優(yōu)化方針函數(shù)是:

其梯度函數(shù)是:

線性鏈CRF的算法

線性鏈CRF詳細(xì)的優(yōu)化完成算法有:改善的迭代標(biāo)準(zhǔn)法IIS���、梯度下降法以及擬牛頓法等��。

其間運(yùn)用較廣的BFGS算法(歸于擬牛頓法)如下:

Set initial value: w(0)

B(0)=I //positive definite matrix

K = 0

while(gk ��!= 0)

}

七�����、算法庫(kù)

前面兩節(jié)講了LR和linear-chain CRF的原理��、方針函數(shù)以及常見(jiàn)學(xué)習(xí)辦法�����。如果我們十分有愛(ài)好自己著手完成算法��,的確能夠develop your own machine learning library from scratch�。

本著了解數(shù)學(xué)模型的目的,自己完成算法作為操練和溫習(xí)���,也是好的。不過(guò)�����,并不主張我們自己拿自己完成的算法在作業(yè)中實(shí)踐運(yùn)用����。

這牽涉到投入和功率的問(wèn)題,如果你看過(guò)Andrew Ng的Machine Learning公開(kāi)課�����,就會(huì)知道���,Andrew Ng是很對(duì)立自己寫實(shí)踐用到開(kāi)發(fā)中的算法的�����。

自己開(kāi)發(fā)算法難于確保質(zhì)量是一個(gè)方面——讓一個(gè)算法運(yùn)轉(zhuǎn)起來(lái)簡(jiǎn)略�����,bug free可就難了���,要害是找到bug都十分不簡(jiǎn)略�。除此之外還要確保功用問(wèn)題���,對(duì)核算資源�、存儲(chǔ)資源的辦理和運(yùn)用問(wèn)題����,這些問(wèn)題和我們重視的模型、算法���、數(shù)據(jù)都沒(méi)有什么聯(lián)絡(luò)����,非要自己投注精力�,很可能和首要作業(yè)彼此操控,而非相得益彰����。

別的,算法完成后和數(shù)據(jù)的接口也是一個(gè)問(wèn)題�。如果我們自己完成算法�,讓它支撐某一種schema的輸入數(shù)據(jù)簡(jiǎn)略��,接納多種����,就要花費(fèi)許多精力時(shí)刻在接口的完成和調(diào)試上。這些都是必不可少的��,但卻又和實(shí)踐事務(wù)相去甚遠(yuǎn)����。

如果運(yùn)用機(jī)器學(xué)習(xí)的目的是為了處理實(shí)踐問(wèn)題��,人家有好的東西���,比自己寫省時(shí)省力功用豐厚還功率高�,為什么要自己造輪子呢�����?仍是選用現(xiàn)已得到證明的現(xiàn)成算法庫(kù)吧�。

現(xiàn)成的算法庫(kù)品類繁多,各種言語(yǔ)根本都能找到通用的算法支撐?�,F(xiàn)在機(jī)器學(xué)習(xí)范疇最長(zhǎng)用的言語(yǔ)是Python,Python 的Scikit-learn庫(kù)中就有許多機(jī)器學(xué)習(xí)算法���。

如果你想自己試試寫算法���,也引薦從Python下手。Numpy庫(kù)中的許多函數(shù)讓開(kāi)發(fā)者能夠在程序中完成雜亂的科學(xué)核算�。

CRF++模型是一個(gè)運(yùn)用很廣的CRF東西包,有Java����,C++, Python��,Ruby�, Perl 等多種言語(yǔ)辦法。以筆者所見(jiàn)�����,實(shí)踐中運(yùn)用CRF模型時(shí)�����,大部分隔發(fā)者都會(huì)選用CRF++����。

八����、模型的優(yōu)化

模型的優(yōu)化能夠從三個(gè)方面來(lái)進(jìn)行:數(shù)據(jù)���、算法和模型����。

操練數(shù)據(jù)的擴(kuò)大����、清洗和預(yù)處理

機(jī)器學(xué)習(xí)的模型質(zhì)量往往和操練數(shù)據(jù)有直接的聯(lián)絡(luò)����。這種聯(lián)絡(luò)首要體現(xiàn)在數(shù)量上,同一個(gè)模型�,在其他條件徹底不變的狀況下,用1,000條train data和100,000來(lái)操練�����,正常狀況下�,成果差異會(huì)十分顯著�����。許多的高質(zhì)量操練數(shù)據(jù)����,是進(jìn)步模型質(zhì)量的最有用手法����。

當(dāng)然,關(guān)于有監(jiān)督學(xué)習(xí)而言��,標(biāo)示是一個(gè)痛點(diǎn)��,一般我們能夠用來(lái)操練的數(shù)據(jù)量適當(dāng)有限�����。在有限的數(shù)據(jù)上�,我們能做些什么來(lái)盡量進(jìn)步其質(zhì)量呢?大概有如下手法:

對(duì)數(shù)據(jù)進(jìn)行歸一化(normalization)�����, 正則化(regularization)等規(guī)范化操作。

選用bootstrap等采樣辦法處理有限的操練/測(cè)驗(yàn)數(shù)據(jù)��,以抵達(dá)更好的運(yùn)算作用���。

依據(jù)事務(wù)進(jìn)行特征選?�。簭氖聞?wù)視點(diǎn)差異輸入數(shù)據(jù)包括的特征����,并認(rèn)識(shí)到這些特征對(duì)成果的奉獻(xiàn)���。在文本處理中��,這一點(diǎn)能夠經(jīng)過(guò)選取輸入項(xiàng)來(lái)完成����,也能夠經(jīng)過(guò)構(gòu)建VSM完成��。

調(diào)參

許多機(jī)器學(xué)習(xí)工程師被戲稱為調(diào)參工程師���。這是由于調(diào)參,是模型操練進(jìn)程中必不可少又十分重要的一步�。

我們現(xiàn)已知道,我們操練模型的目的就是為了得到模型對(duì)應(yīng)公式中的若干參數(shù)�����。這些參數(shù)是操練進(jìn)程的輸出,并不需求我們來(lái)調(diào)����。

除了這些參數(shù)外,還有一類被稱為超參數(shù)的參數(shù)��,例如用梯度下降辦法學(xué)習(xí)LR模型時(shí)的步長(zhǎng)(Alpha)���,用BFGS辦法學(xué)習(xí)Linear-chain CRF時(shí)的權(quán)重(w)等�。這些參數(shù)是需求模型操練者自己來(lái)設(shè)置和調(diào)整的��。

調(diào)參自身有點(diǎn)像一個(gè)完好的project����,需求閱歷:

擬定方針

擬定戰(zhàn)略

履行

驗(yàn)證

調(diào)整戰(zhàn)略-> 3.

這樣一個(gè)完好的進(jìn)程,其間3-5步往往要經(jīng)由重復(fù)迭代�。

調(diào)參有許多現(xiàn)成的辦法可循,比方grid search�����,我們能夠自行檢索學(xué)習(xí),運(yùn)用這些辦法���,使得指定和調(diào)整戰(zhàn)略有章可循�����,也能夠削減許多作業(yè)量����。

算法庫(kù)自身關(guān)于各個(gè)算法的超參數(shù)也都有默認(rèn)值��,第一次上手測(cè)驗(yàn)操練模型����,能夠從默認(rèn)值開(kāi)端,一般也能得出成果��。

模型挑選

有的時(shí)分����,操練數(shù)據(jù)現(xiàn)已既定��,而某個(gè)模型再怎樣調(diào)參����,都無(wú)法滿意在某個(gè)特定方針上的要求�����。那就只好換個(gè)模型試試了���。比方LR不可,還能夠換Decision Tree或許SVM試試����。

現(xiàn)在還有許多深度學(xué)習(xí)的模型也逐漸投入運(yùn)用。不過(guò)一般狀況下���,DL模型(CNN��,DNN��,RNN��,LSTM等等)關(guān)于操練數(shù)據(jù)的需求比我們今日講的核算學(xué)習(xí)模型要高至少一個(gè)量級(jí)���。在操練數(shù)據(jù)缺乏的狀況下,DL模型很可能功用更差����。

并且DL模型的操練時(shí)刻遍及較長(zhǎng)�����,可解釋性極弱���,一旦呈現(xiàn)問(wèn)題,很難debug����。因而再次主張我們:在運(yùn)用場(chǎng)景下,不要迷信cutting edge technology�,不管東西仍是辦法,選對(duì)的����,別選貴的。

閱歷雜談

之前在作業(yè)中開(kāi)發(fā)Bot產(chǎn)品時(shí)��,筆者也自己寫過(guò)目的辨認(rèn)和實(shí)體提取的模型操練/猜測(cè)程序�。

詳細(xì)做法是:結(jié)構(gòu)VSM;導(dǎo)入語(yǔ)料將VSM的輸出成果作為某一種特定算法(例如LR�,DT,CNN等)的輸入進(jìn)行操練�����;得出模型后經(jīng)過(guò)穿插驗(yàn)證調(diào)參�����;在當(dāng)時(shí)算法下抵達(dá)F1 Score最優(yōu)后���,再橫向比較幾種不同的模型�,終究選出全體最優(yōu)的模型�����。

在這樣的進(jìn)程中�,所操練算法,不管是Logistics Regression仍是Fast Tree(Decision Tree的一種)��,都是用的現(xiàn)成的Library���,都沒(méi)有自己寫�����。

最開(kāi)端自己構(gòu)建VSM是為了操控feature的挑選���,比方是分詞仍是n-gram�����,切分gram之后是核算tf-idf仍是信息熵�,等等�。

可是后來(lái)發(fā)現(xiàn),關(guān)于一個(gè)模型好壞的影響�,詳細(xì)的feature挑選比不上操練數(shù)據(jù)自身的質(zhì)量的影響大。

LUIS自身供給了十分友愛(ài)的用戶界面��,能夠很便利的進(jìn)行數(shù)據(jù)標(biāo)示�,并且VSM的構(gòu)建盡管針對(duì)性不強(qiáng),可是融入了多任務(wù)學(xué)習(xí)等辦法���,使得generic model質(zhì)量不差�����。盡管我們的產(chǎn)品����,由于concurrency和lantency的要求比較高�,終究仍是沒(méi)有選用LUIS�����,可是筆者信任,關(guān)于普通用戶��,在前期Bot開(kāi)發(fā)中運(yùn)用LUIS會(huì)是一個(gè)很好的挑選���。